In unserem Projekt Fun with Robots ging es nicht nur ums Löten und Schrauben, sondern vor allem um eins: Technik erlebbar machen – mit Spaß, Neugier und Kreativität möchten wir Kinder und Jugendliche für Technik begeistern.

Unser Ziel bleibt: frühzeitig Interesse an Technologie zu wecken und die Tüftler:innen von morgen zu inspirieren – mit selbstgebauten Robotern, die nicht perfekt sein müssen, aber richtig Charakter zeigen.

Unsere Roboter im Überblick

🐶 Laufende Hunde

Unsere Roboterhunde setzen sich mit einfachen Schrittabfolgen in Bewegung und zeigen, wie bereits mit wenigen Servos eine fortlaufende Gehbewegung realisiert werden kann.

🦀 Krabbe

Unsere Krabbe ist durch ihre unregelmäßigen Bewegungsmuster besonders auffällig. Sie bewegt sich nicht linear, sondern folgt einer vorhersehbaren Route.

🐰 Hase

Dieser kleine Kerl will hoch hinaus. Mit einem selbstgebauten Hoppelmechanismus imitiert er ein echtes Hasenhüpfen – fast wie in freier Wildbahn, nur mit Servos.

🔧 Gabelstapler

Nicht nur süß, sondern auch praktisch: Unser kleiner Gabelstapler kann nach vorne fahren und sogar seine Gabel heben und senken

🤖 Wall·E

Wall·E ist ein besonders auffälliger Roboter voller Überraschungen innerhalb unserer Sammlung – nicht nur wegen seines Designs, sondern auch durch die Art, wie er sich bewegt und mit seiner Umgebung interagiert.

🐞 Rollender Käfer

Klein, rund, schnell – Unser rollender Käfer zeichnet sich durch eine überraschend hohe Geschwindigkeit und Wendigkeit aus. Und er fährt auch gerne mal davon, bevor man „Stopp“ sagen kann.

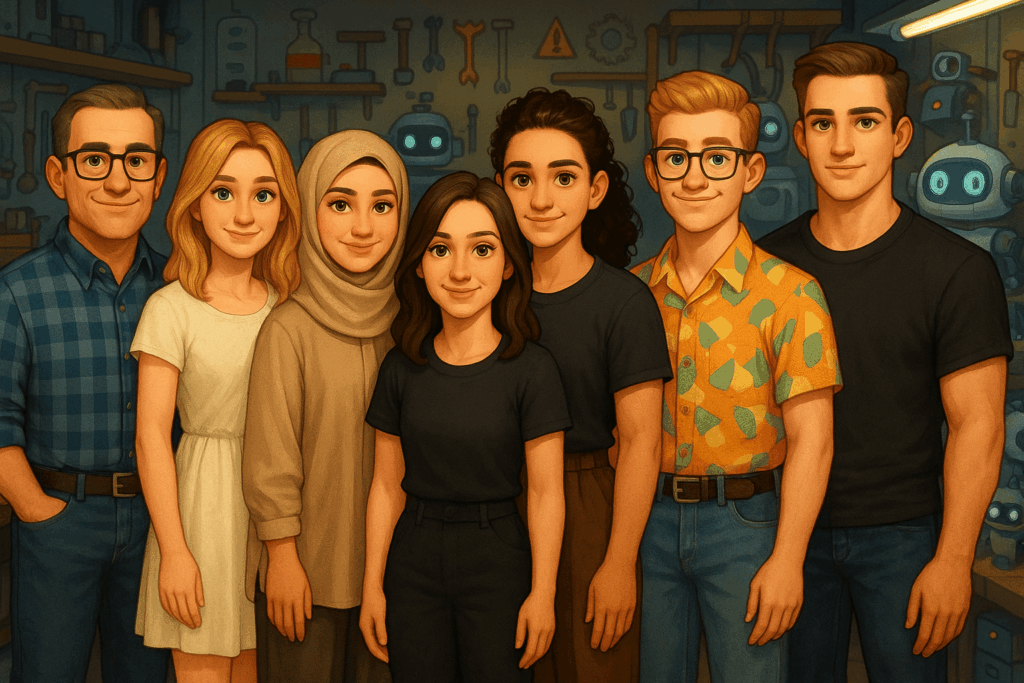

Über uns

Fun with Robots wurde als Projektarbeit im 5. und 6. Semester im Studiengang Media Engineering an der Technischen Hochschule Nürnberg ins Leben gerufen.

Wir – Annika Neubauer, Aylin Gökce, Ece Nur Keles, Merve Özkan, Tilo Brockmann und Yannick Rosenauer – sind ein Team aus sechs Studierenden, das mit viel Begeisterung, Neugier und Teamgeist an der Idee gearbeitet hat, Technik spielerisch erlebbar zu machen.

Unterstützt wurden wir dabei von Prof. Dr. Ralph Lano, der uns als Projektbetreuer mit Rat und Erfahrung zur Seite stand.

Neugierig geworden?

Folgt uns auf Instagram, um noch mehr spannende Einblicke in unser Projekt zu bekommen! Wir teilen kurze Videos unserer Roboter in Aktion und spannende Updates rund um Fun with Robots.

Wenn du sehen willst, wie unsere Projekte lebendig werden, schau gern vorbei!

Quelle: © TH Nürnberg

Quelle: © TH Nürnberg