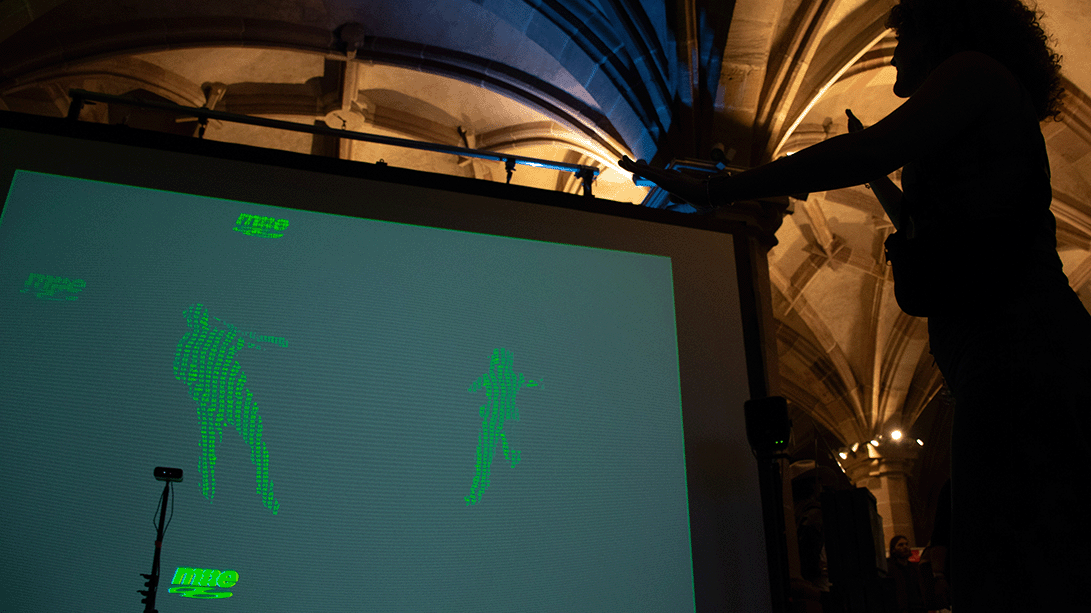

Lumina Pax (lat. Licht, Frieden) ist eine immersive Lichtinstallation, die im Mai 2025 als Projektarbeit der Studierenden des 5. und 6. Semesters Media Engineering auf der Blauen Nacht in Nürnberg präsentiert wurde.

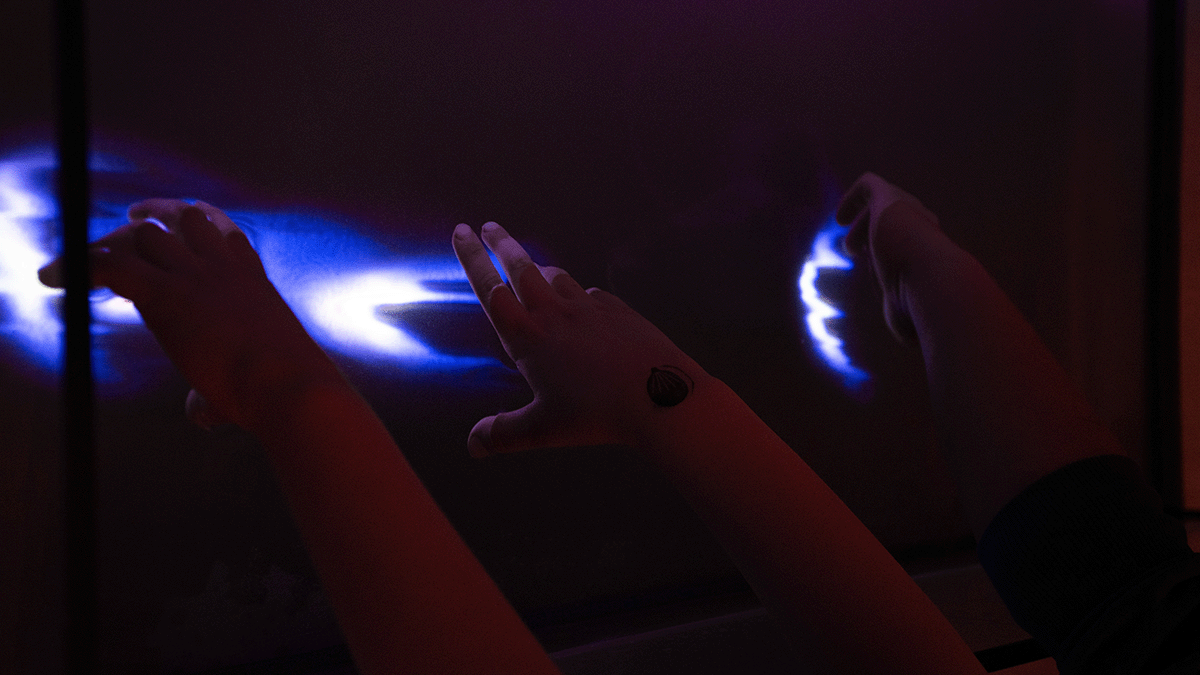

In den Nürnberger Felsengängen schwebten leuchtende Origami-Tauben durch die Dunkelheit und erfüllten die unterirdische Mauer mit Leben. Die Verbindung aus Licht, Klang und der historischen Atmosphäre der Felsengänge entführte die Besucher:innen auf eine eindrucksvolle Reise voller Symbolik und Emotion.

Blaue Nacht

80 Jahre nach dem Ende des Zweiten Weltkriegs erstrahlt Die Blaue Nacht am 17. Mai 2025 unter dem Motto „Love and Peace“. Inspiriert von der rebellischen Leichtigkeit und dem farbenfrohen Ausdruck der Hippie-Bewegung steht das Thema für den Wunsch nach weltweitem Frieden, gelebter Solidarität und einem offenen, demokratischen Miteinander. Es ist ein Ruf nach Hoffnung, Gemeinschaft und dem Vertrauen darauf, dass Kunst Veränderung möglich macht.

Kurzdokumentation

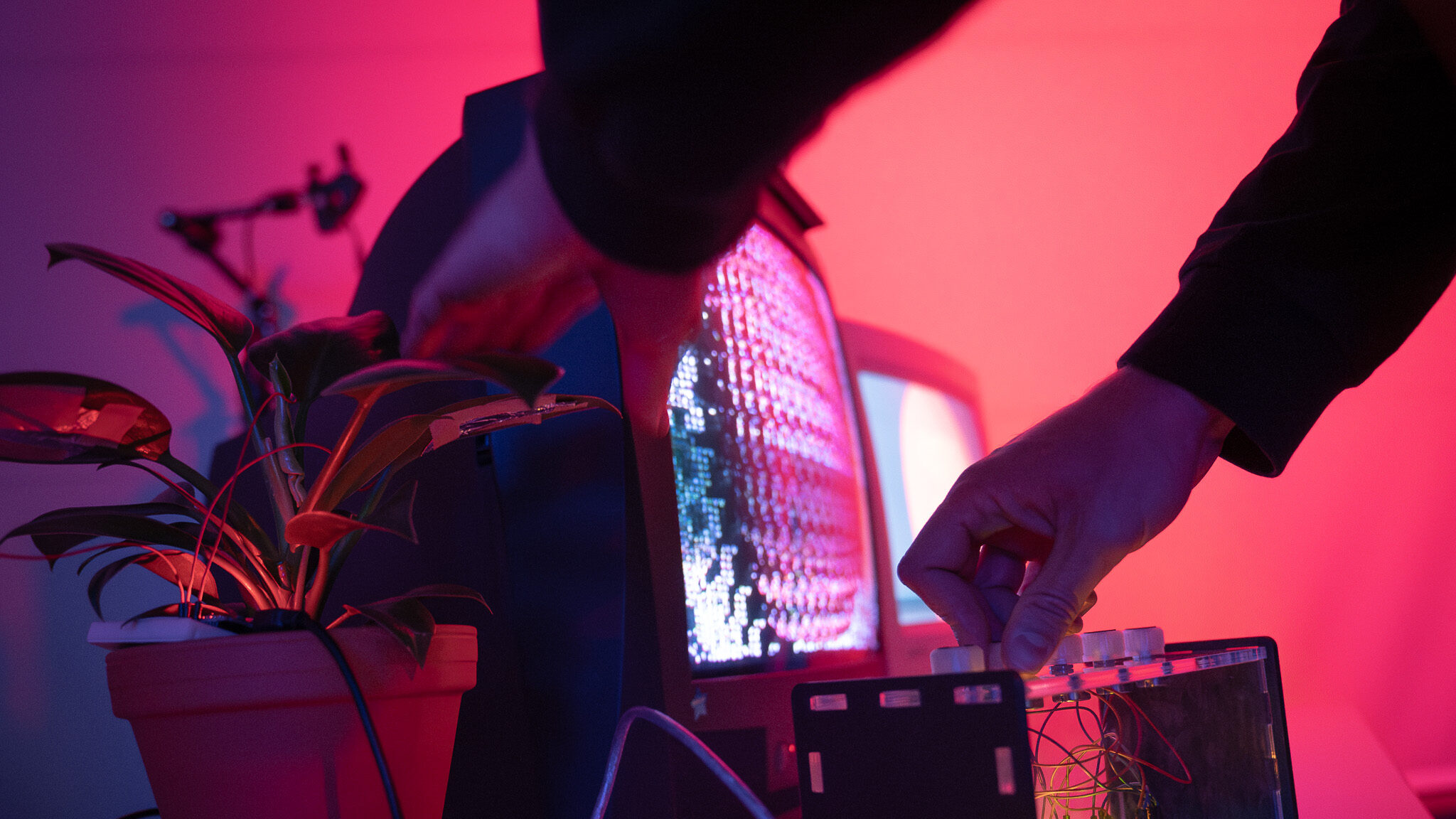

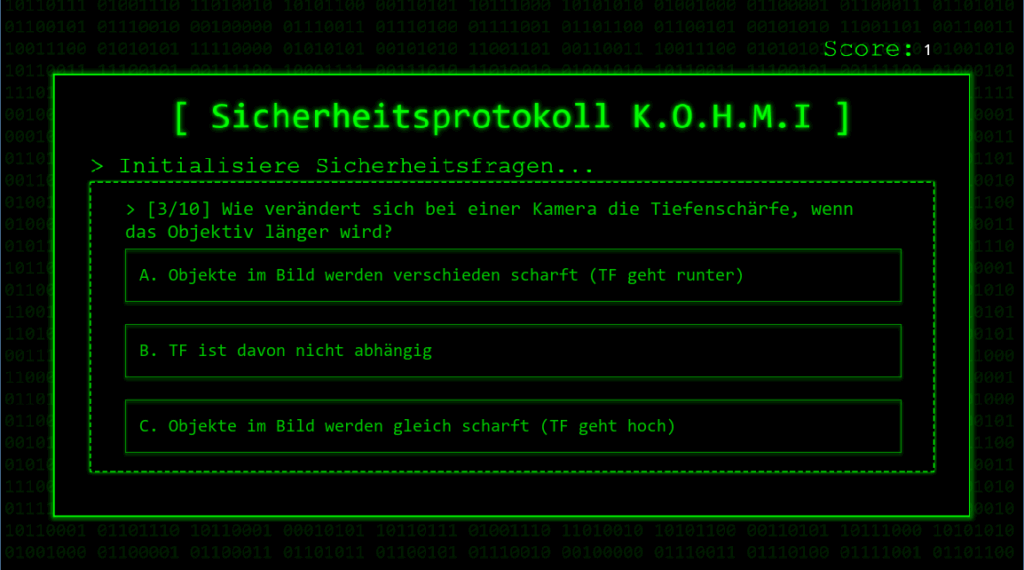

Die Umsetzung des Projekts erfolgte mit der Game Engine Godot. Animationen, Scripting, Shader und Mapping wurden vollständig in Godot realisiert. Für die Modellierung der Objekte, wie der Ziegelsteinwand, kam Blender zum Einsatz.

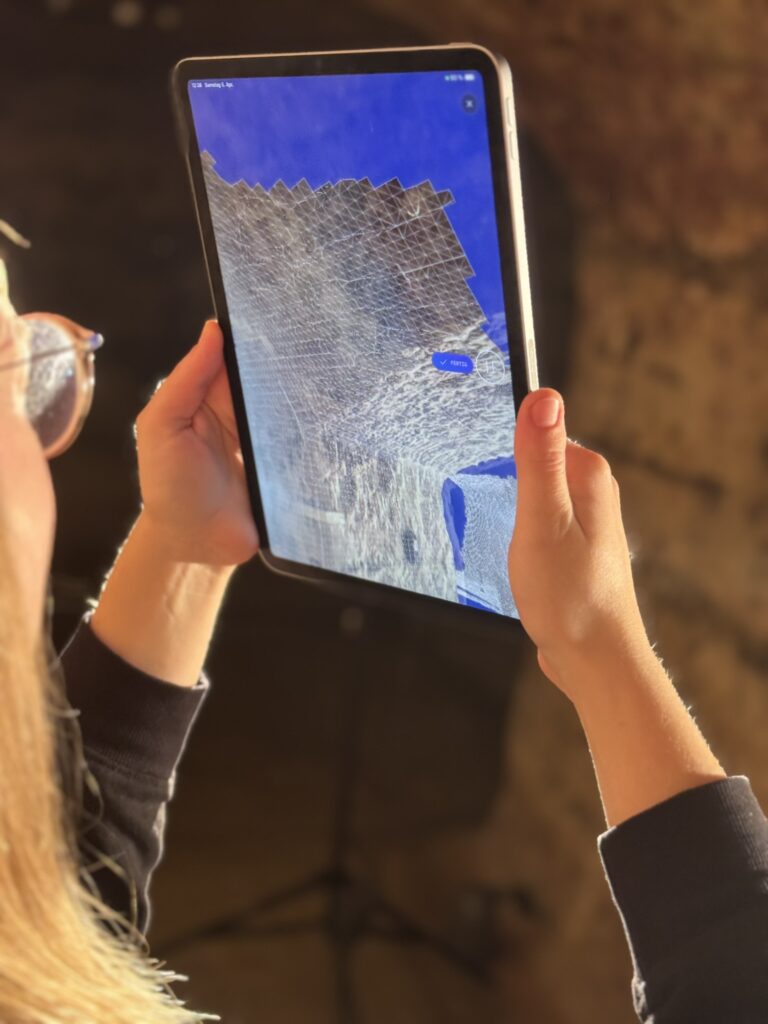

Bevor wir mit der Umsetzung begonnen haben, wurde die Location mithilfe des LiDAR-Sensors eines iPads und der Software Polycam gescannt. Das daraus erzeugte 3D-Modell diente als Ausgangspunkt für unsere virtuelle Szene – um dieses Modell herum entwickelten wir alle weiteren Elemente.

Eine besondere Herausforderung bestand darin, die einzelnen Ziegel präzise zu erfassen und so zu mappen, dass die Projektion nahtlos mit der realen Struktur übereinstimmt.

Mithilfe des Projection Mappings gelang es uns, digitale Inhalte exakt auf die physische Oberfläche abzustimmen und ein immersives visuelles Erlebnis zu erzeugen.

Mit der Wand als Grundlage konnten wir unser Konzept umsetzen, welches wir auf das Motto der Blauen Nach abgestimmt haben. Die Wand öffnet sich und Origami-Tauben erwachen zum Leben. Sie symbolisieren Frieden und finden die wahre Liebe. Abgerundet werden die schönen Animationen durch eingebaute Sounds. Die Vorstellung brachte das Publikum der Blauen Nacht zum Schmunzeln und Lachen.

Über uns

Wir sind ein kreatives und engagiertes Team von Studierenden im Bereich Media Engineering an der OHM Nürnberg.

Unsere Leidenschaft liegt darin, Technik und Kunst miteinander zu verbinden und innovative Ideen in die Realität umzusetzen.

Quelle: KI generiert durch ChatGPT

Quelle: KI generiert durch ChatGPT

Quelle: © TH Nürnberg

Quelle: © TH Nürnberg